LM Studio: 比Ollama更好用的大模型部署工具

Ollama作为当前流行的大语言模型部署工具,但其以命令行方式运行需要搭配其他UI工具使用;并且对非N卡设备并不友好,虽然针对Intel显卡有成熟的解决方案[1][2],但是使用起来仍然复杂。而LM Studio支持多种 GPU,包括 AMD 和 Intel 的显卡,这使得即使不拥有 NVIDIA 设备的用户也能充分利用其硬件资源来运行复杂的 AI 模型。

相比 Ollama, LM Studio 的优势如下:

- 利用 vulkan 适配多种GPU(AMD、Intel、Intel Arc、NVIDIA等等)

- 自带图形化界面,上手简单

- 选项功能丰富

- 支持大模型丰富,可以运行huggingface上gguf格式的LLM模型文件

安装

访问LM Studio 官网,下载对应版本安装文件。

![LM Studio 官网]()

双击已下载的安装包,根据提示完成安装。

设置

安装后主界面如下,可以根据个人喜好修改设置。后续操作都在高级用户模式下操作,请在软件底部选择 Power User

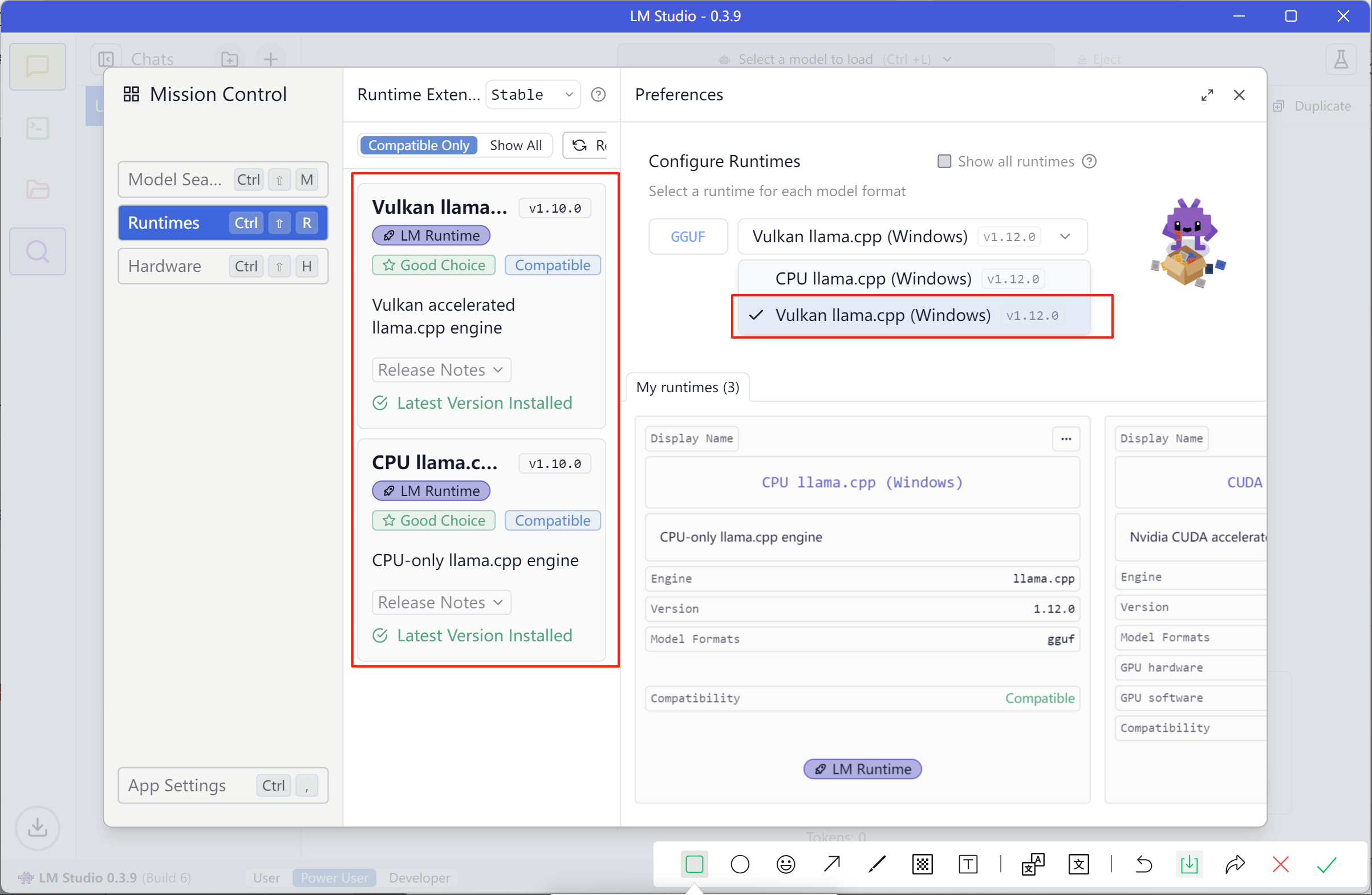

- 确认计算机是否支持GPU, 点击 右下角设置 选择 Runtimes,如果如图所示,除了

CPU ollama.cpp还有其他 Runtime(如图中的Vulkan ollama.cpp)则说明当前计算机可以使用 GPU加速大语言模型推理。![LM Studio Runtime]()

- 在模型搜索中选择喜欢的模型进行下载如图所示

![LM Studio 模型下载]()

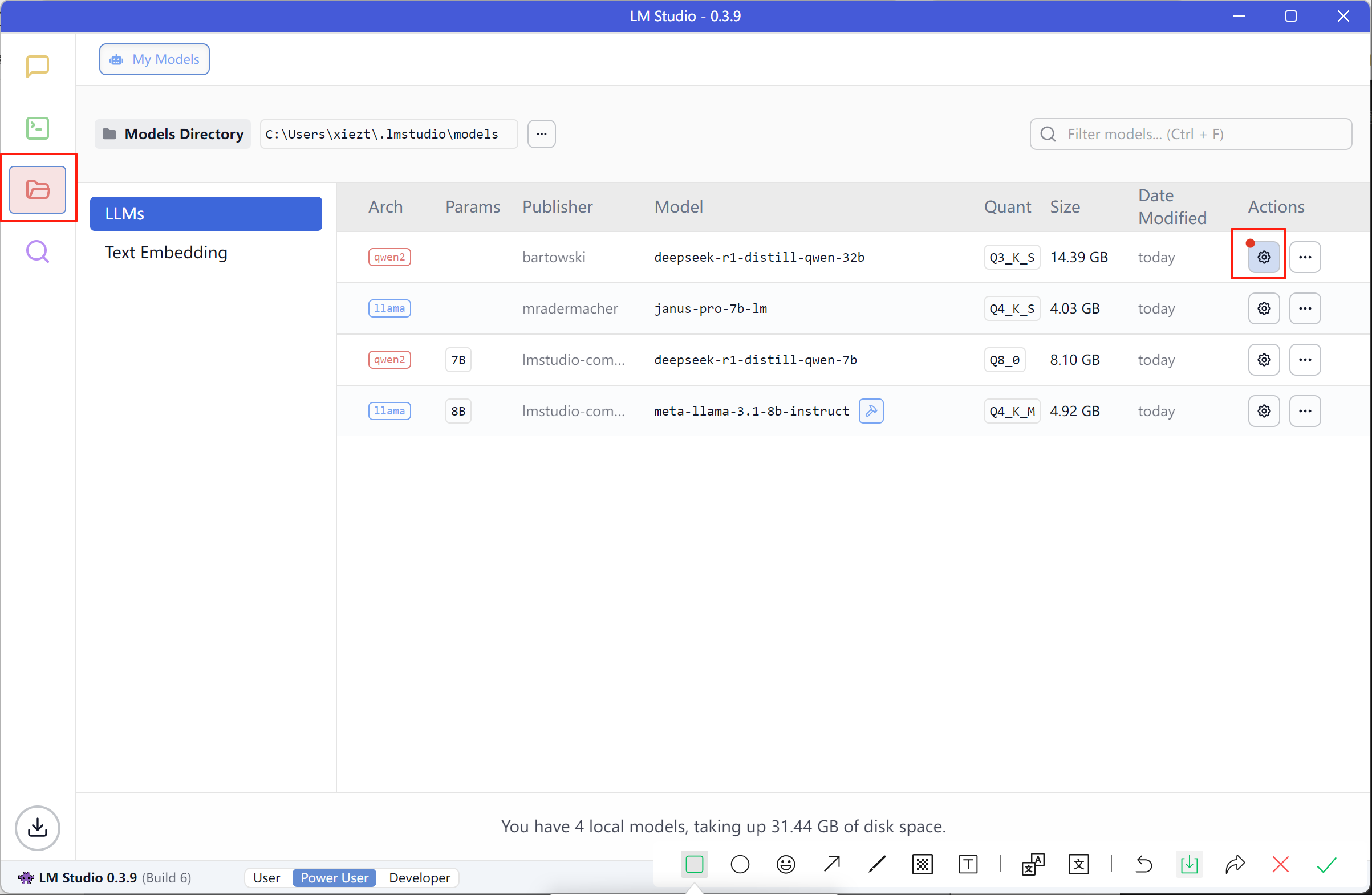

- 在模型管理中个性化设置模型

![LM Studio 模型管理]()

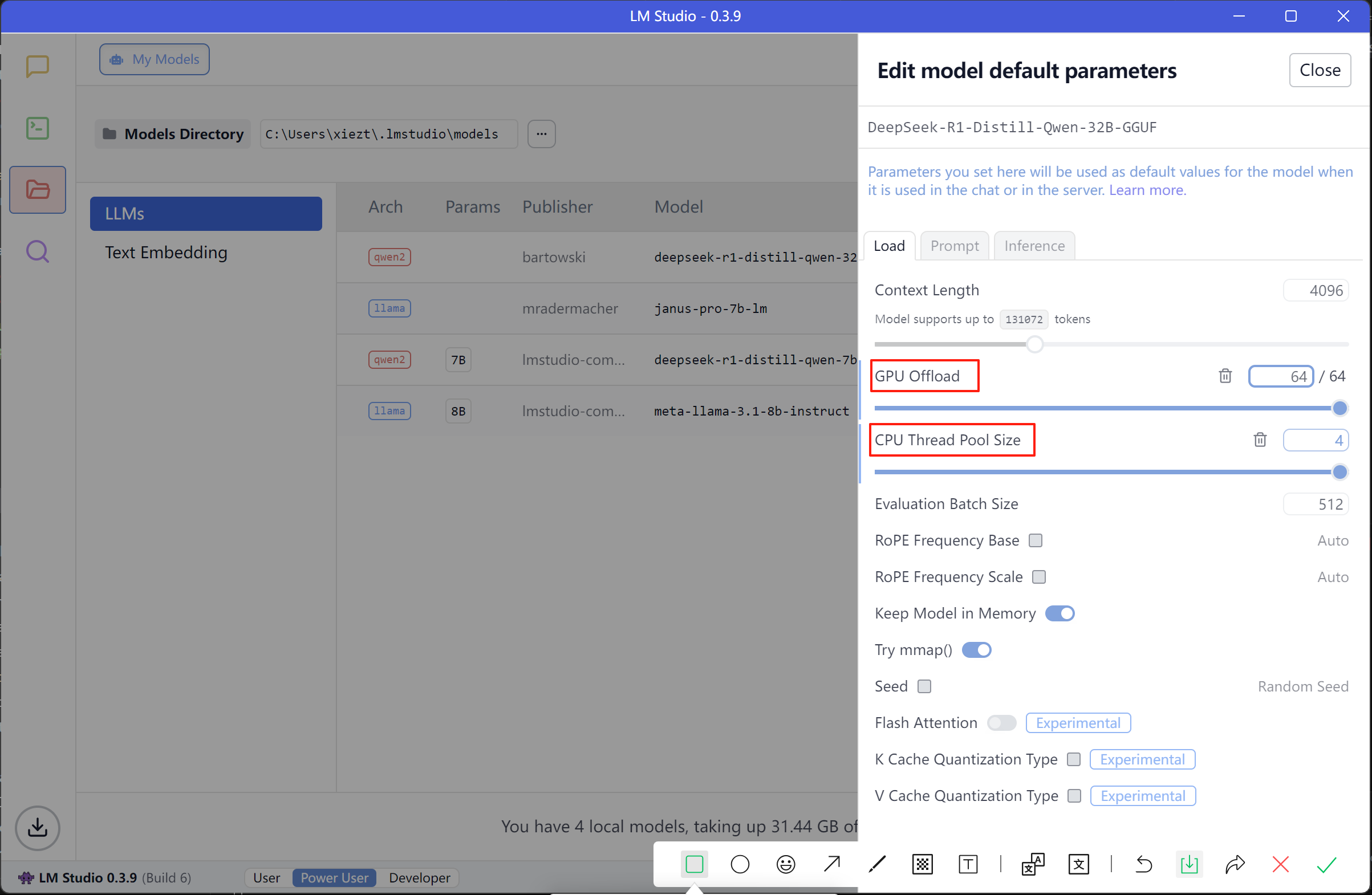

- 将GPU Offload和CPU Thread Pool Size拉满,如果 GPU Offload 则无法调用 GPU。

![LM Studio 模型设置]()

使用

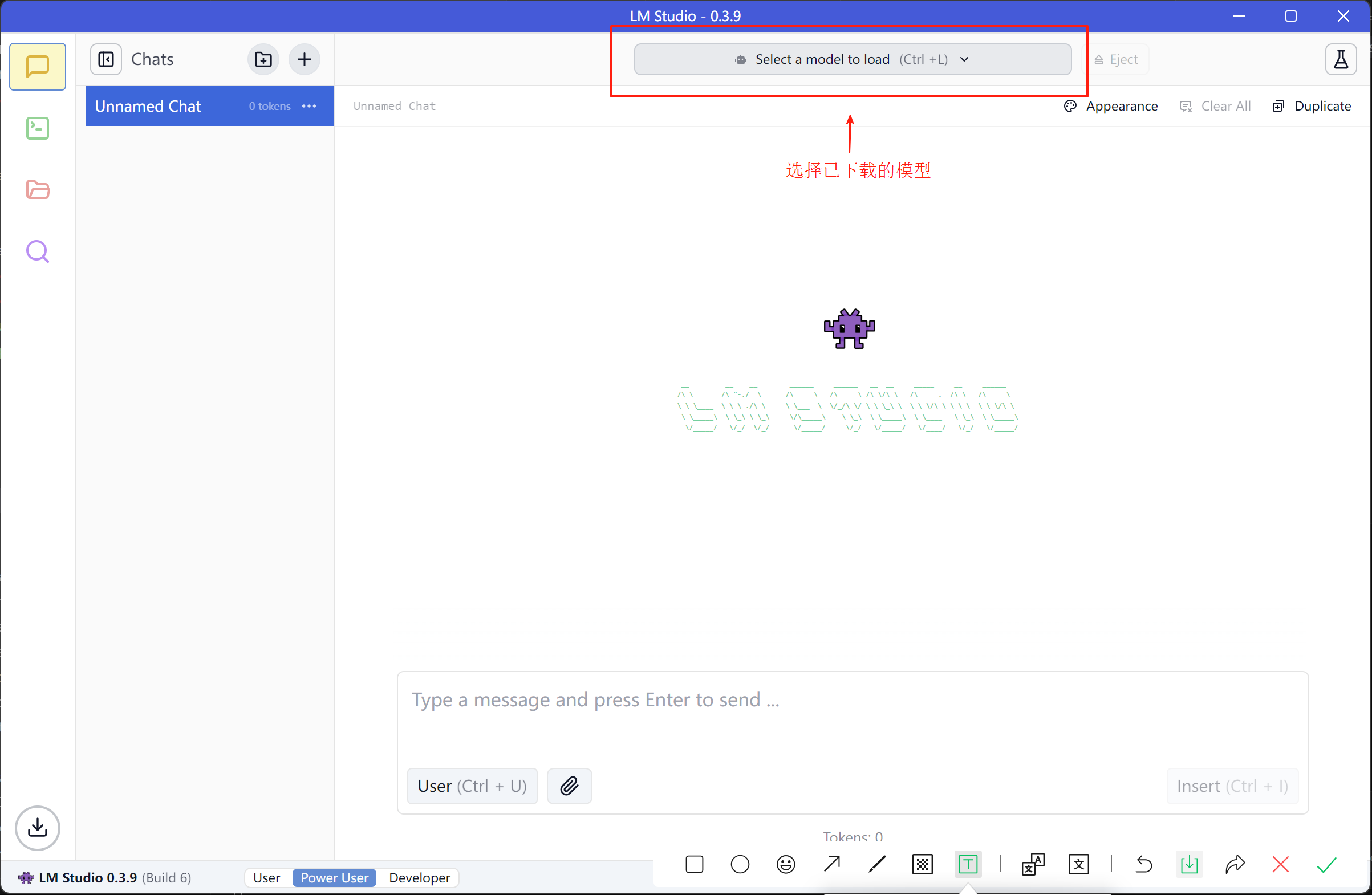

在顶部选择以下载的模型加载使用

![LM Studio 模型选择]()

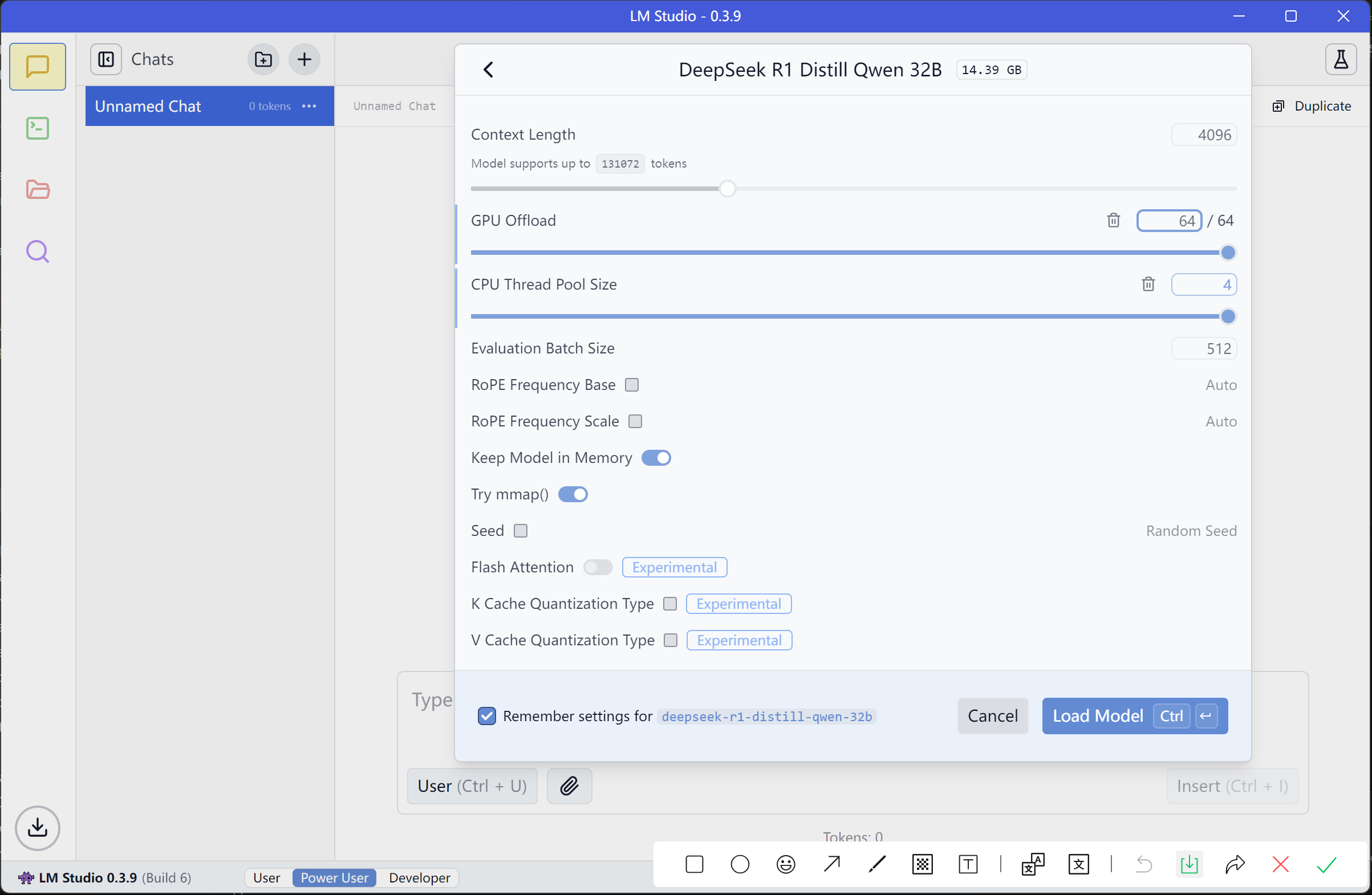

选择时亦可对大模型进行设置

![LM Studio 模型设置]()

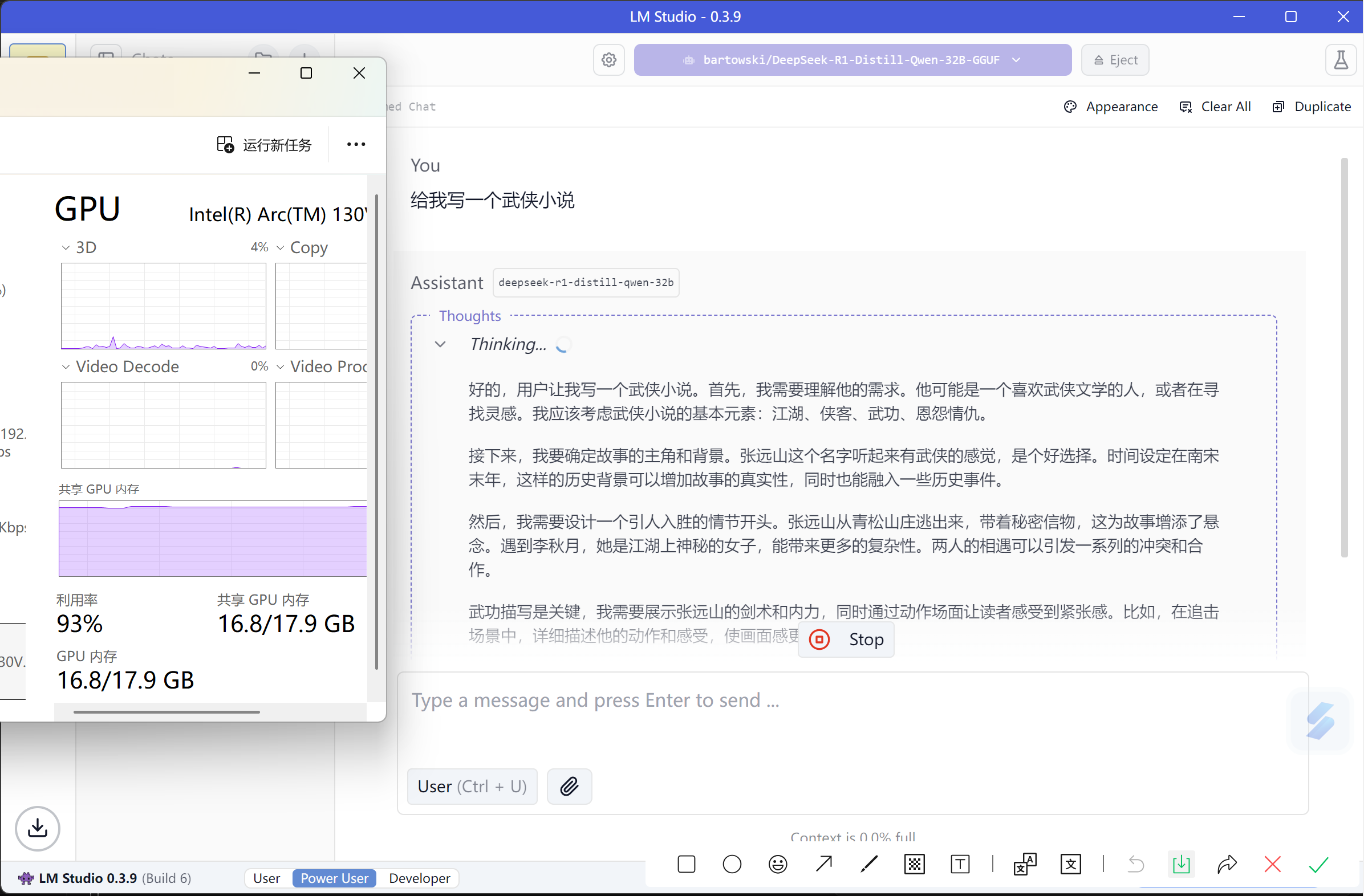

选择后等待顶部进度条完成即模型加载完成,加载完成后即可使用,使用时可以看到LM Studion 正在使用GPU进行推理

![LM Studio 模型使用]()

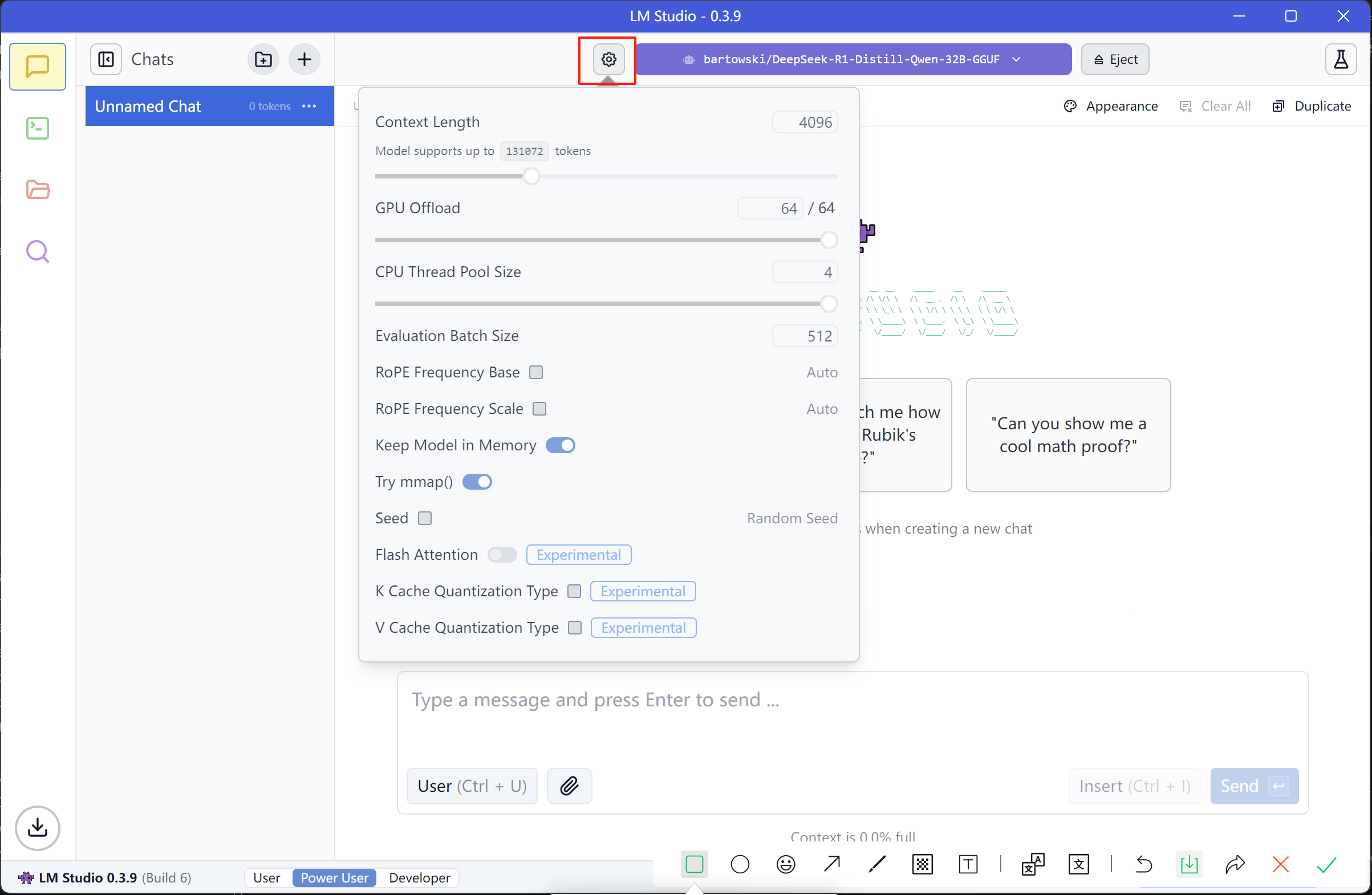

使用时可以在左边设置图标修改模型设置

![LM Studio 模型设置]()